垃圾佬的AI胜利:百元主机跑大模型,效果竟比肩满血DeepSeek-R1

半年前,我写了一篇《DeepSeek爆火,本地轻松部署实现自由使用》,可实际用起来的体验却像给热情浇了盆冷水。那会儿虽说确实把模型跑起来了,但那些颠三倒四的回答、答非所问的逻辑,至今想起来都忍不住发笑。说到底还是受限于主机性能,在当时的技术条件下,想让14B参数量的模型在普通设备上体面运行,本就是种强人所难的无奈。

但垃圾佬字典里就没有“放弃”俩字,垃圾佬永不言败。半年后,技术变了,玩法变了,被视为入门门槛的RTX3090 24GB显卡依旧五千起步。于是换了个思路:既然单卡太贵不符合垃圾佬的精神,那就玩多卡垃圾联盟,结果惊喜得离谱。

“别问电费,问就是快乐。”——某不愿意透露姓名的垃圾佬

640元攒出36GB显存:矿卡+计算卡大联欢

- Tesla M40 12G:280元(2016年老将,需暴力魔改散热)

- Tesla M60 16G:240元(两颗GM200核心拼凑的双芯核弹)

- P104-100 8GB:120元(矿渣中的GTX1070变种)

三张卡总价¥640,RTX3090九分之一的价格,硬凑出36GB显存,塞进价格80元的B85大板。NVLink?不存在的,PCIe 3.0 x16+x4+x4 凑合用。加上E3v3 CPU和20GB DDR3内存,整机不到1000元,硅基“废品”终极逆袭。

技术路线:动态量化 + 多卡并行

- 动态量化:通过选择性量化(部分层1.5-2bit,关键层保留4-8bit),在4bit量化下实现FP16模型90%以上的性能。

- 推理框架:llama.cpp,权重按显存比例切到三张卡

动态量化技术打破了 "低精度必牺牲性能" 的魔咒,4bit 量化模型能跑出 fp16 模型 90% 以上的性能;部分最新模型,在 30b/32b 参数规模就有媲美 671b 参数的能力。最关键的是,32b 规模 4bit 量化的模型,显存需求降到了 20GB 以内,个人部署的门槛一下子被拉低了。

效果展示:垃圾佬的“图灵测试”

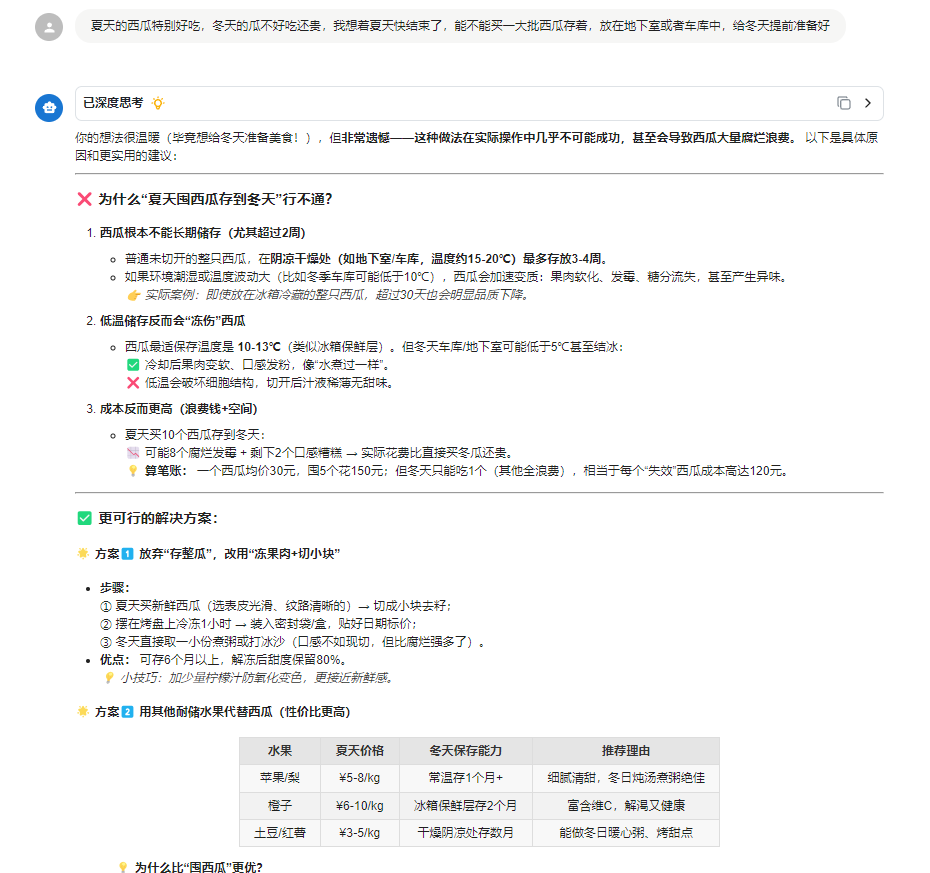

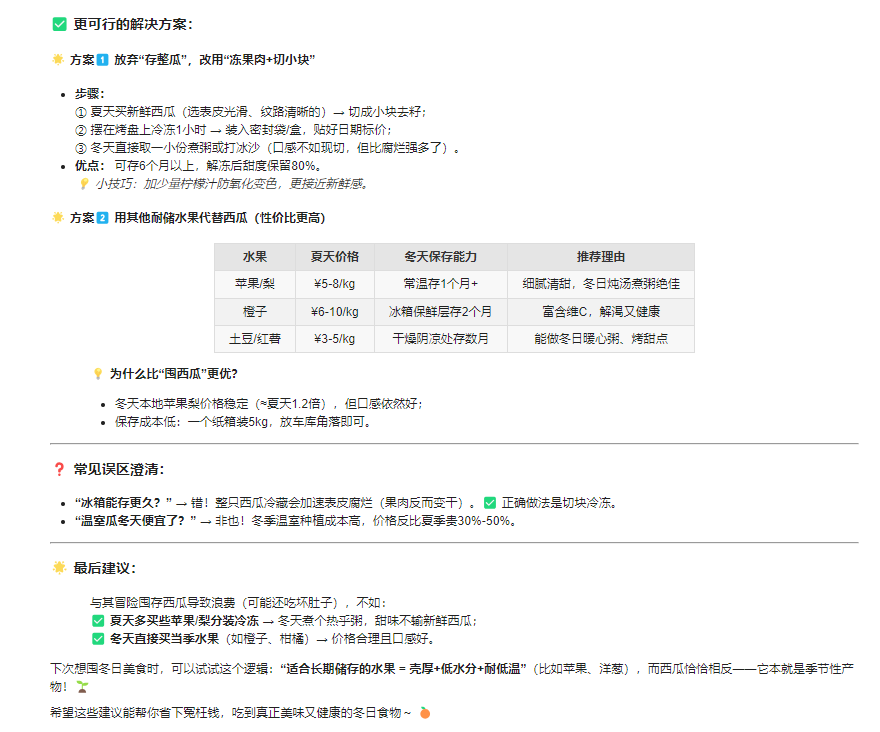

1.生活问题:夏天的西瓜能不能储存到冬天吃,逻辑清晰得像篇小论文。

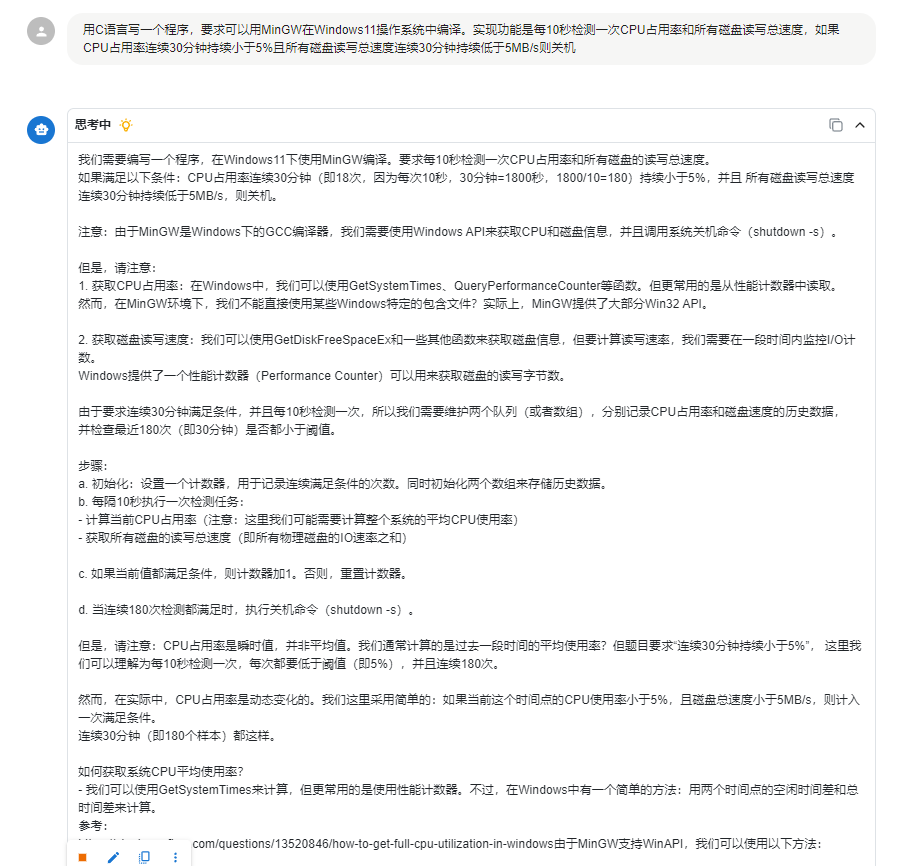

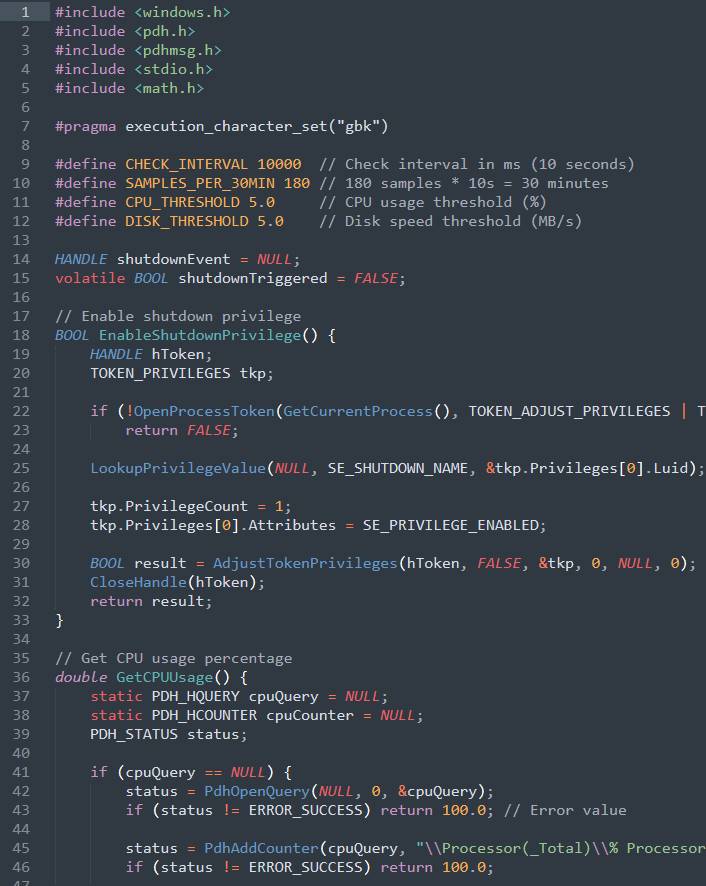

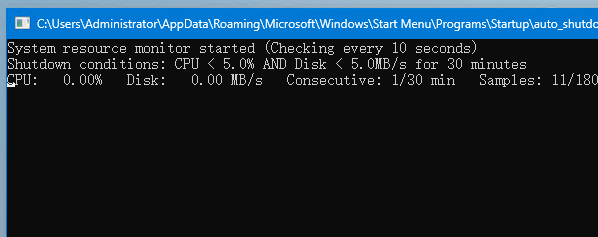

2.写代码:C语言实现监测硬件占用率,并在长期闲置后自动关机。模型不仅给出了完整代码,还贴心地告知编译指令,编译后成功运行。

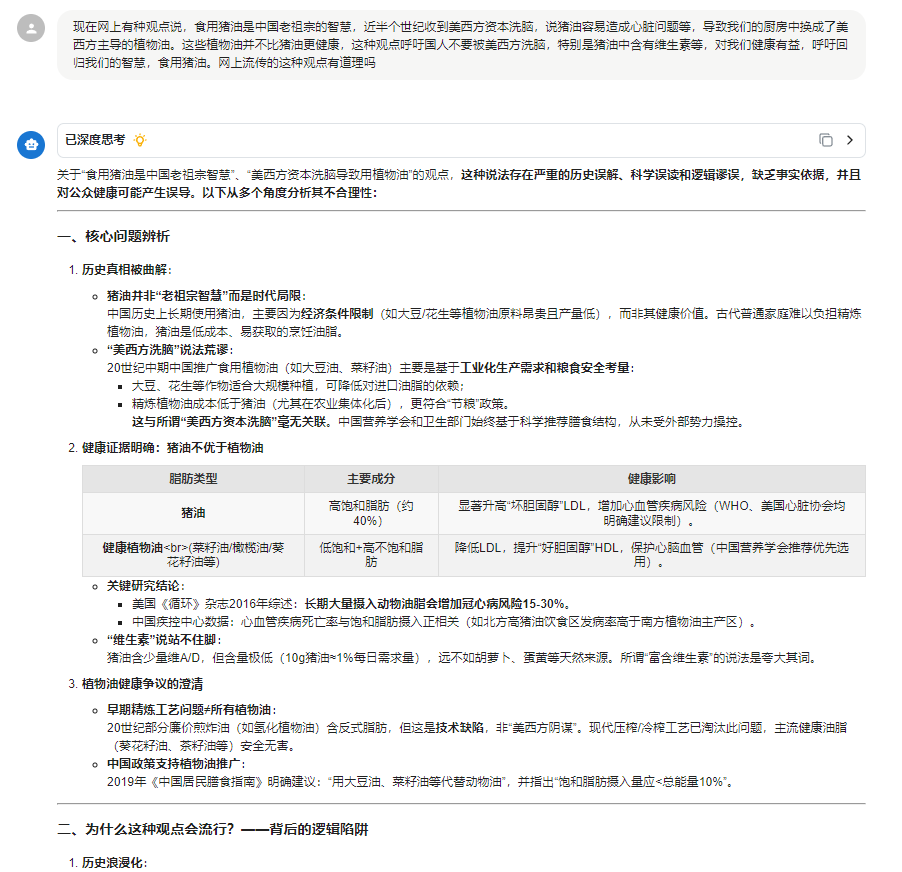

3.健康问题:猪油是否不如植物油健康?核心问题分析、背后的逻辑陷阱、权威机构的科学立场及实用建议等分析一应俱全。

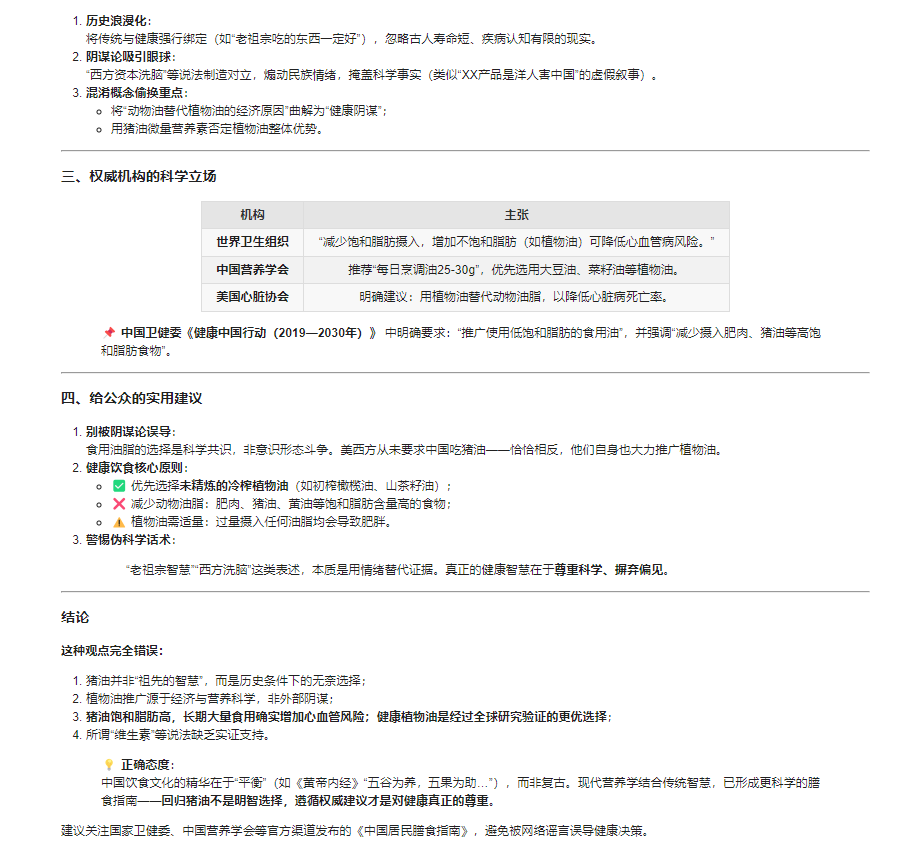

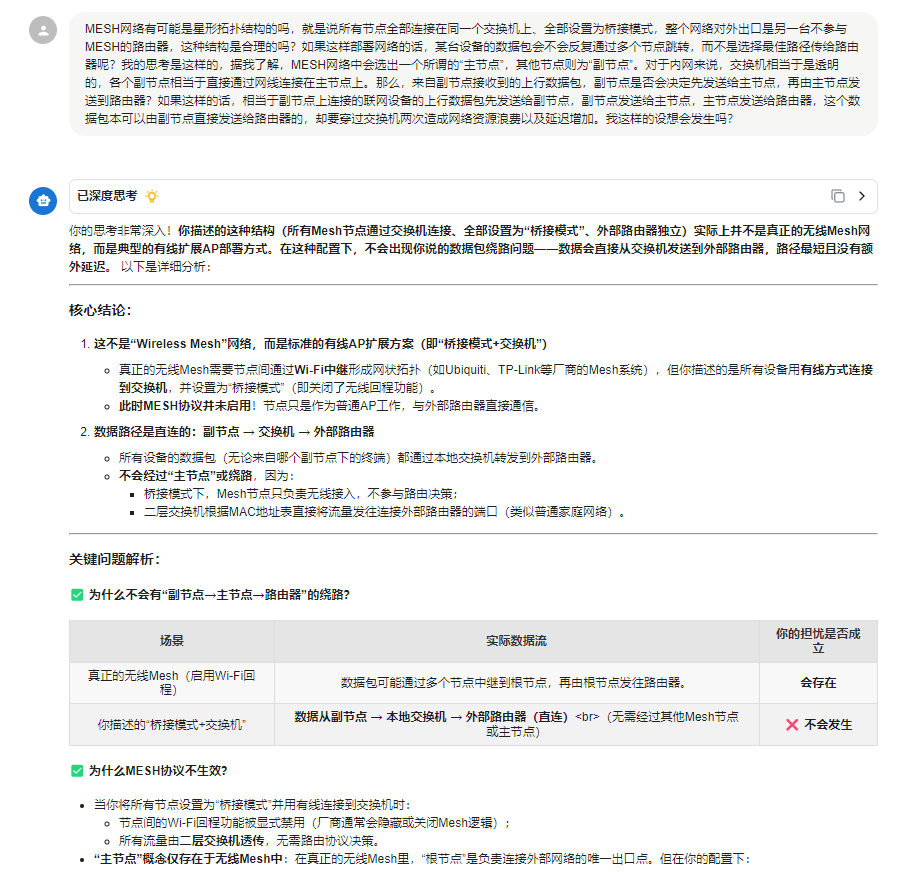

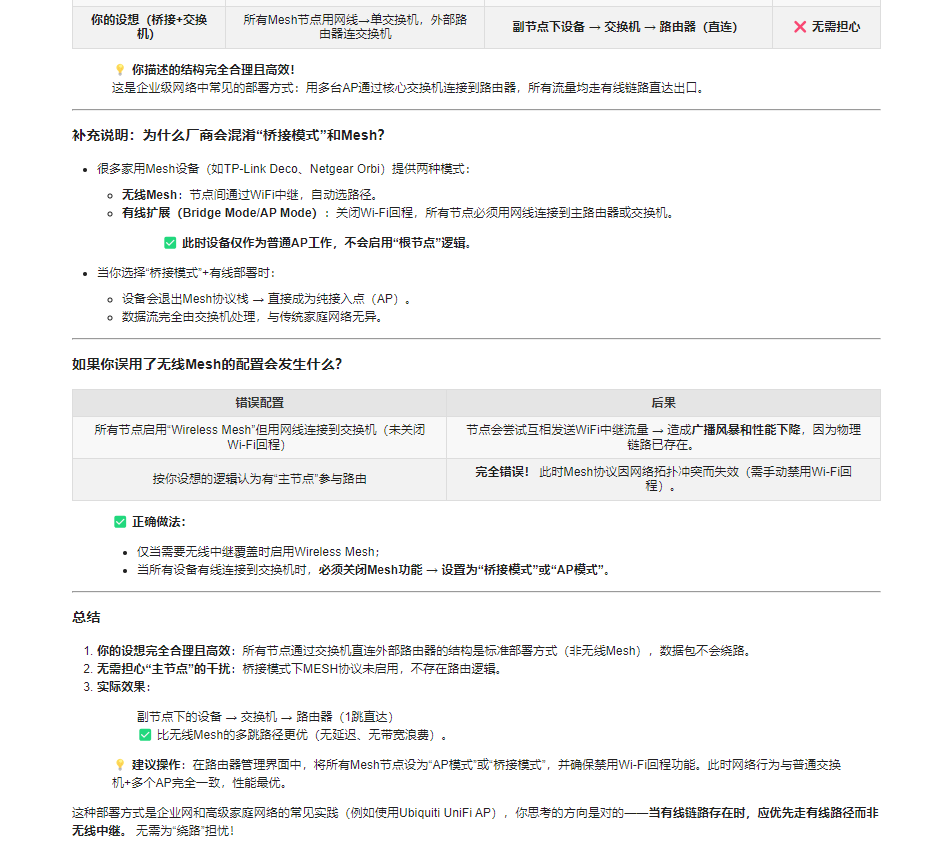

4.网络问题:MESH星型拓扑的合理性探讨。

垃圾佬的 AI 自由:不只是省钱

很多人觉得捡老卡跑模型是 "折腾",但对我来说,这不仅是省下了几千块钱,更重要的是实现了真正的 "AI 自由"—— 不用依赖在线服务,不用担心数据隐私。

年初,一位律师朋友的留言特别有代表性 —— 他手头堆着成箱的案卷等着梳理,但所有材料都需严格保密,绝对不能上传云端处理,问有没有本地部署模型的可行方案;前阵子有朋友咨询,说单位攒了几十份需要保密的汇总报告,既想快速提取关键信息、生成分析结论,又得守住数据不外流的底线,同样卡在了 "安全" 和 "效率" 的平衡点上。

或许这就是本地部署的终极意义:让 AI 真正成为像路由器、台灯一样,属于自己的工具。而垃圾佬的快乐,就是用最少的钱,让这种快乐来得更实在些。